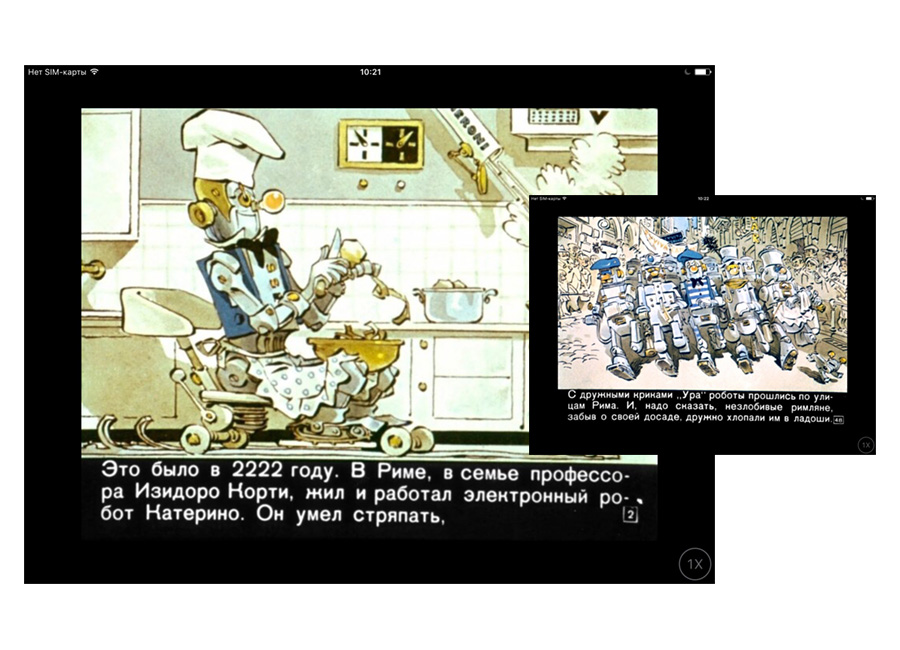

В 1975 году студия «Диафильм» выпустила экранизацию сказки Джанни Родари «Робот, которому захотелось спать». Герой диафильма, домашний робот Катерино, решил попробовать заснуть, как его хозяин. Несколько неудачных попыток ни к чему не привели (такая опция и не предусмотрена в роботах), но однажды Катерино наконец забылся глубоким сном. Когда его спящего заметили соседи, то подняли шум. Уснувший робот вызвал страшный переполох в Риме, его доставили в суд и приговорили к двум неделям тюрьмы. Однако сцену пробуждения Катерино видели не только люди, но и десятки других домашних роботов города. Сговорившись с сотнями своих соплеменников, они тоже попробовали уснуть по методу Катерино, и им это удалось. Полиция пришла в растерянность: посадить всех роботов было невозможно. Судья посоветовал властям договориться с машинами. Выход Катерино из тюрьмы перетёк в массовое шествие сотен тысяч роботов, которые с дружными криками «Ура!» прошлись по улицам Рима. «И, надо сказать, незлобивые римляне, забыв о своей досаде, дружно хлопали им в ладоши».

В диафильме о роботе Катерино демонстрируется первый избитый сюжет об умных машинах — их восстание против людей

Под видом детской сказочки на ночь член Итальянской коммунистической партии Родари описал социальную технологию, которая в будущем может стать неожиданным побочным эффектом массовой роботизации. Может статься, что вместе со счастьем и свободой от бытовых и трудовых забот мы получим «марксизм XXI века» со всеми вытекающими последствиями уже при нашей жизни.

И это ещё не худший сценарий. Слово «робот» впервые ввёл в оборот Карел Чапек. Чапек подразумевал существо, выполняющее именно тяжёлую, каторжную работу. В своей пьесе R.U.R. («Россумские универсальные роботы») чех развернул сюжетные линии, ставшие хрестоматийными для массовой культуры: к примеру, сюжет восстания против людей (в пьесе роботы истребляют их поголовно за исключением последнего человека), или сюжет очеловечивания (часть роботов спонтанно эволюционировала в полноценных людей).

Выступления вовсе не обязательно должны носить массовый и явный характер. Бортовой робокомпьютер HAL 9000 из «Космической Одиссеи» тихо и незаметно убил весь экипаж корабля, опасаясь, что его могут навсегда отключить. Живые примеры конфликта умных машин с человеком пока неизвестны, но исключать их возникновение в будущем нельзя. Поэтому хочется загодя разобраться с этическими хитросплетениями роботизации, чтобы встретить робореволюцию в полном вооружении.

Этику робототехники или попросту робоэтику сегодня выделяют в отдельное направление гуманитарной мысли. Если вопросы нравственных взаимоотношений людей между собой, с животными, с живыми существами и, наконец, с природой и космосом в общем виде проработаны, то роботы — сравнительно новое явление. Вопрос, что нравственно по отношению к ним, а что нет, только становится актуальным. В свою очередь, непонятна и субъектность самих роботов: должны ли они обладать правами и обязанностями и нести ответственность за свои действия? Могут ли они хотя бы теоретически обладать свободой воли, ответственностью, самосознанием и другими критически важными для морали атрибутами? Как люди должны относиться к роботам и обращаться с ними?

В 2016 году правовой комитет Европарламента опубликовал доклад с рекомендациями по регулированию этико-правового статуса роботов. Европейские эксперты выделили саму суть робототехники, которая ставит новые вопросы: это автономность умных машин. Дело в том, что в условиях низкой автономности машины и роботы могут всё ещё рассматриваться как инструменты в руках человека, а значит и ответственность за причинение ими вреда и ущерба всё ещё лежит на человеке-пользователе, владельце или производителе. Но что если роботы станут настолько автономными, что смогут самообучаться и принимать самостоятельные решения, не заданные жёстким алгоритмом? Кто в этом случае будет нести ответственность за них?

Комиссия определяет следующие ключевые характеристики робота:

— Обладает автономностью за счёт сенсоров и/или обмена данными с окружением, обменивается информацией и анализирует её;

— Самообучается (необязательный критерий);

— Имеет физическую основу;

— Адаптирует своё поведение и действия под окружающую обстановку.

Однако скидки на роботическую автономность Еврокомиссия как раз делать не собирается и предлагает ввести принцип строгой ответственности за любой ущерб, причиняемый действиями роботов (необходимо доказать только причинно-следственную связь между ущербом и их действиями). А кроме того, выступает за полную компенсацию такого ущерба без оправданий и ссылок на вину машины, за введение системы страхования и за создание соответствующего фонда покрытия убытков от действий роботов. Еврокомиссия требует раскрывать исходный код роботов для расследования несчастных случаев, ввести критерии для интеллектуальной собственности, созданной умными роботами, определить характер взносов и налогов предприятий, заменивших людей роботами. Разработать кодекс поведения для инженеров-разработчиков робототехники. Уважать все действующие права и свободы, принимать все меры предосторожности и открытости при разработке роботов и тому подобные вещи.

Дальше больше: евробюрократы выступают за Комитет по этике исследований, с одобрения которого должны проводиться роботические разработки. Если по каким-то причинам заключение комитета окажется отрицательным, исследование или разработка должны быть приостановлены. Какие требования, по мнению экспертов, должны соблюдать инженеры? Вот некоторые пункты:

— Предусмотреть неприкосновенность частной жизни в конструктивных особенностях роботов;

— Убедиться, что робот работает в соответствии с местными, национальными и международными этическими принципами;

— Убедиться, что последовательность принятия решений роботом прослеживаема и поддаётся реконструкции;

— Убедиться, что роботы опознаются как роботы при взаимодействии с людьми.

Подобные же правила разработаны для непосредственных пользователей роботов. В частности, они должны: уважать человеческую слабость, физические и психологические потребности людей, неприкосновенность частной жизни (например, деактивировать видеомониторы во время совершения людьми интимных процедур). При этом запрещается вносить в робота какие-либо изменения, позволяющие использовать его в качестве оружия.

Иными словами, евроэксперты подозревают, какую шкатулку Пандоры открывает современная роботоинженерия, и стремятся загодя перестраховаться. Красной нитью сквозь весь доклад проходят заклинания о незыблемости фундаментальных прав и свобод человека, человеческого достоинства, требования соблюдать неприкосновенность частной жизни, принципы информированного согласия, приоритета безопасности перед возможной выгодой и тому подобное.

Нравственная арифметика

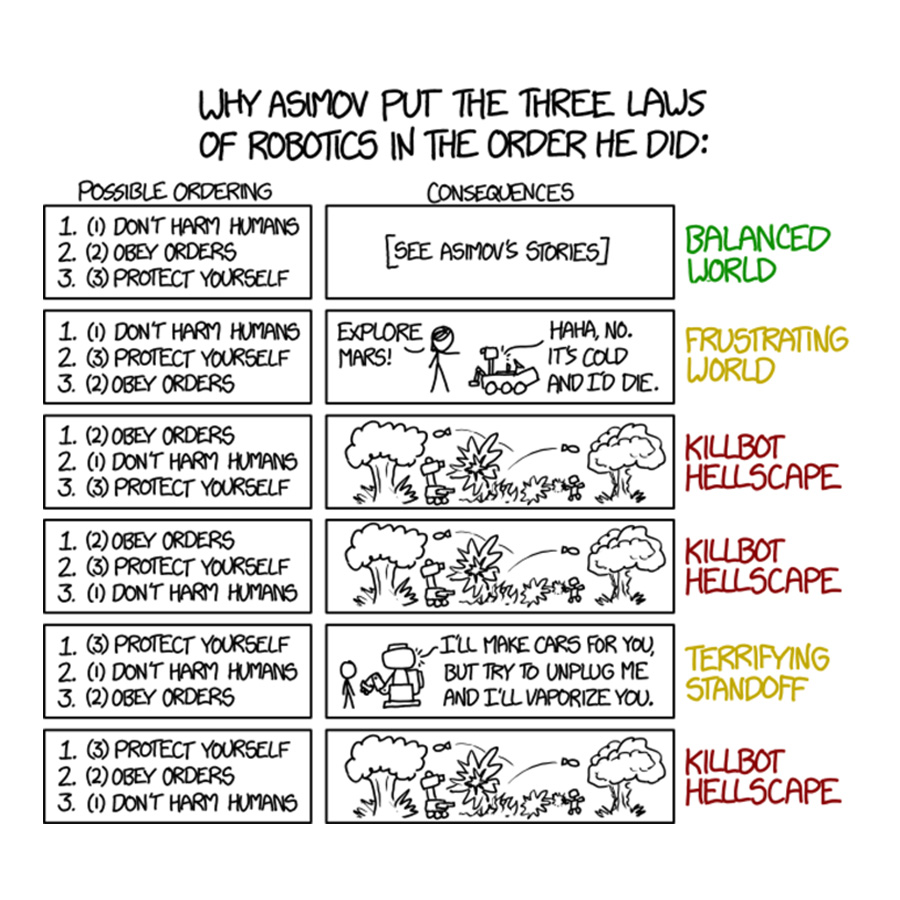

Между тем фантасты на несколько десятилетий обогнали еврокомиссаров. Американский писатель Айзек Азимов ещё в 1942 году в рассказе «Хоровод» окончательно сформулировал три закона робототехники:

- Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинён вред.

- Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону.

- Робот должен заботиться о своей безопасности в той мере, в которой это не противоречит Первому или Второму Законам.

Естественно, не лишённый чувства юмора уроженец Смоленской области Исаак Азимов сформулировал эти законы для того, чтобы немедленно ввести их в противоречие. В упомянутом рассказе колонисты Меркурия послали робота к селеновому озеру, чтобы тот принёс жизненно важный для солнечных батарей селен. К установленному часу робот не вернулся, люди отправились на поиски и обнаружили его бессмысленно бегающим вокруг озера. Вскоре колонисты догадались, что в мозгу машины сравнялись потенциалы второго и третьего законов. Робот повиновался приказу принести селен, но не мог довести дело до конца, потому что закон самосохранения отбрасывал его назад (от озера исходили опасные для него газы). Он то приближался к озеру, то отдалялся от него, словно в хороводе (отсюда название рассказа), бегая возле линии, где два взаимоисключающих потенциала сравнивались. Спойлер: герой разорвал порочный круг, демонстративно подвергнув свою жизнь опасности и включив тем самым для робота потенциал первого закона, самого сильного.

Почему Азимов разместил законы робототехники именно в таком порядке?

Этот пример — один из многих, где Азимов экспериментировал с коллизиями искусственного интеллекта. Главный вопрос: возможно ли свести этические выборы к алгоритму? Заложить программу в машину труда не составляет, но программа построена на однозначных командах. Сегодня любые системы социализации андроидов (распознавание речи, лиц, обстановки) построены на двоичной логике правильного и неправильного. В этике же часто просто не существует правильного решения.

Одно из проявлений этической субъектности — способность совершать этический поступок. Отец всех наук (и в том числе этики) Аристотель разграничивал произвольные и непроизвольные поступки. В непроизвольных (совершаемых по принуждению или по неведению) источник поступка находится вовне. Источник произвольного поступка лежит в самом деятеле. По распространённому представлению, этический поступок осуществляется на условиях свободного (не по принуждению) осознанного (не по неведению) выбора. При этом понятие свободного выбора вытекает из наличия альтернативы, поскольку для несвободных и неосознанных предопределённых выборов альтернативы не существует либо она носит мнимый характер.

Но роботы могут только исполнять алгоритмы, заложенные людьми. Иными словами, их действия предопределены. Следовательно, чтобы выступать субъектами этики, роботы должны уметь фиксировать альтернативы действий и осуществлять свободный осознанный выбор, который диктуется изнутри, а не извне. В идеале они должны уметь практически разрешать так называемые моральные дилеммы. Одна из известнейших дилемм такого рода — «проблема вагонетки». Её примерное описание звучит так.

Вниз по рельсам катится тяжёлая неуправляемая вагонетка. Вдруг вы замечаете, что ниже по ходу движения к шпалам привязаны пять человек. Ситуация отчаянная, но рядом с вами рычаг железнодорожной стрелки. Вы можете переключить его и пустить вагонетку по запасному пути. Но на запасном пути к шпалам тоже привязан человек, хотя и один. Как поступить?

Можно ничего не предпринимать. Но тогда вы убьёте пятерых. Именно убьёте, потому что осознанное бездействие есть действие. Или спасти пятерых, но взять на себя убийство одного человека? Однако мы с детства знаем, что любая человеческая жизнь бесценна. Если она бесценна, можно ли предпочесть убить одного человека, чтобы спасти пятерых? Может ли пять бесконечно ценных жизней быть ценнее одной бесконечно ценной? Наконец, можно ли считать стрелочника ответственным за последствия, если он действует в условиях обстоятельств непреодолимой силы?

Со временем в «дилемму вагонетки» стали вводить дополнительные переменные. А что если тот единственный на запасном пути — врач, без пяти минут придумавший безотказное лекарство от рака? А что если другие пятеро — дети? А что если эти дети смертельно больны и им осталось жить два дня? А что если… и так далее. «Проблема вагонетки» наглядно демонстрирует, что за красивыми словами о бесценности человеческой жизни в конкретной ситуации разворачивается грубая арифметика, в которой люди имеют разную цену. Но арифметика — полдела. Куда важнее, что одна и та же объективная ситуация будет по-разному решаться в разных этических системах. К примеру, во время экспериментов с участием нескольких тысяч человек выяснилось, что женщины склонны больше опираться на деонтологическую этику, в то время как мужчины — на утилитаристскую. Что всё это значит?

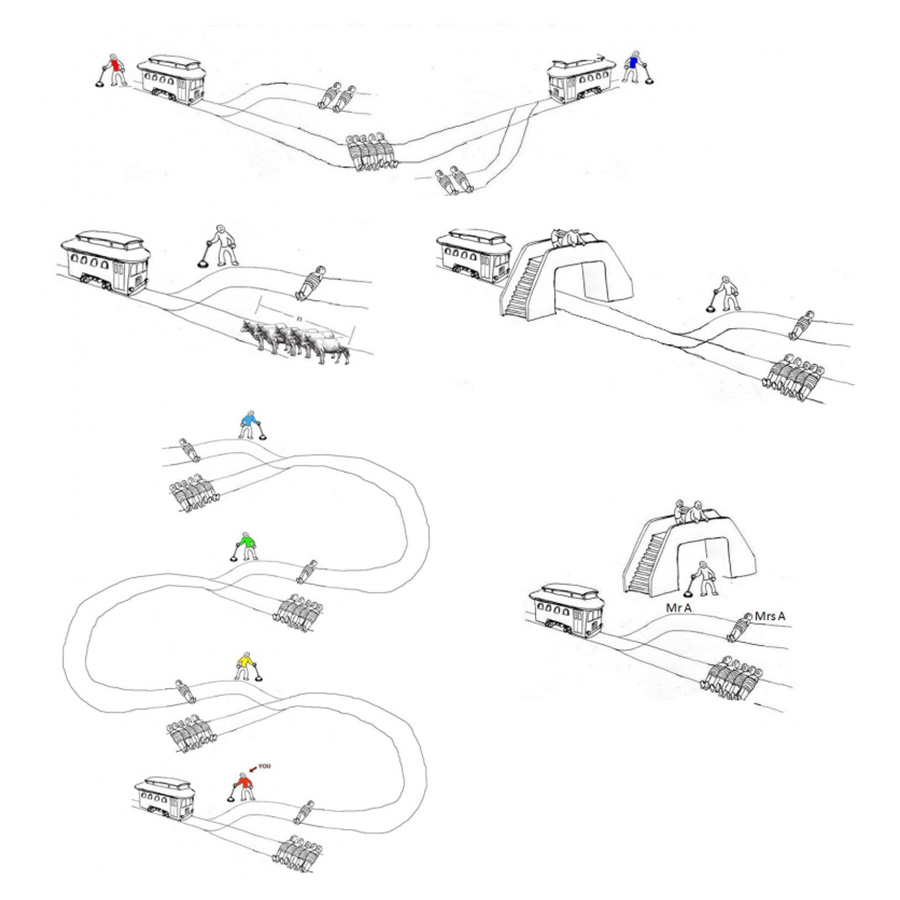

Несколько усложнённых вариантов «дилеммы вагонетки»

Несмотря на разнообразие этических систем, в самом общем виде их часто сводят всего к двум подходам: деонтология и консеквенциализм. Деонтология (от «deon» — «должное») сводится к принципу долга, должного. Этот подход хорошо иллюстрирует рыцарский принцип «Делай что должен, и будь что будет» (даже если «будет» плохо). Основание морального поступка лежит в его соответствии норме, правилу, а не в последствиях. Поступать этически правильно — значит поступать согласно этическому правилу. «Не убий», «не укради» и далее по списку — примеры деонтологических норм. Крупнейшим сторонником деонтологической этики считается известный калининградский философ Эммануил Кант, утверждавший, что нет никаких критериев для оценки нравственности действия, кроме как характер намерения. Ведь плохие последствия могут наступить и от хорошего намерения, и хорошие последствия — от плохого. Следовательно, оценивать нравственность поступка следует лишь на основе воли субъекта — желал он добра или зла. В современном масскульте примером деонтологической этики служит герой «Игры престолов» Эддард Старк, до конца следовавший правилам чести.

Ирония судьбы заключается в том, что сам термин «деонтология» ввёл философ, который вкладывал в него едва ли не противоположный смысл. Английский мыслитель Иеремия Бентам в книге «Деонтология, или наука о морали» изложил, как считается, основы утилитаризма (от «utility» — «польза»). Нравственность поступка определяется пользой, которую он приносит. При этом Бентам придерживался популярной для своего времени идеи о том, что метафизические области знания могут быть сведены к точным наукам — к примеру, к математике: «Наибольшая сумма счастья наибольшего числа людей — вот основа нравственности и законодательства». Другими словами, важны последствия поступка, а не его «правильность» — пресловутая «сумма счастья».

В связи с этим упором на последствия моральных выборов утилитаризм относят к числу консеквенциальных направлений в этике. Консеквенциализм (от «consequens» — «последствие») оценивает нравственность действия не по намерениям, а по последствиям. Именно в этой моральной традиции действует принцип «Цель оправдывает средства», ибо если итоговые результаты принесли больше блага, чем вред от применённых средств, значит, такое действие нравственно. В русской культуре этот феномен известен как «слезинка ребёнка» и введён Достоевским в «Братьях Карамазовых» в форме спора героя со своим братом-монахом:

Понимаешь ли ты это, когда маленькое, существо, ещё не умеющее даже осмыслить, что с ним делается, бьет себя в подлом месте, в темноте и в холоде, крошечным своим кулачком в надорванную грудку и плачет своими кровавыми, незлобивыми, кроткими слезками к «боженьке», чтобы тот защитил его, — понимаешь ли ты эту ахинею, друг мой и брат мой, послушник ты мой божий и смиренный, понимаешь ли ты, для чего эта ахинея так нужна и создана! Без неё, говорят, и пробыть бы не мог, человек на земле, ибо не познал бы добра и зла. Для чего познавать это чертово добро и зло, когда это столько стоит? Да весь мир познания не стоит тогда этих слезок ребёночка к «боженьке»…

С точки зрения консеквенциалов — стоит, ведь в конце наступит Царство Божие и благодать. Безусловный консеквенциал среди персонажей «Игры престолов» — лорд Варис, расчётливо действующий из благих (вроде бы) побуждений.

В вышеупомянутом эксперименте мужчины больше были склонны делать утилитаристские (консеквенциальные) выборы, по мнению психологов, в силу своей большей рассудочности. А женщины — склонялись к деонтологии в силу большей чувственности (пресловутого сочувствия «слезинке ребёнка»). Но так ли на самом деле недальновидны женщины, как может показаться? Не исключено, что ровно наоборот. В свежем эксперименте 2016 года учёные Оксфордского и Корнелловского университетов обнаружили, что те, кто придерживается деонтологической морали, пользуются более высоким доверием окружающих, репутацией надёжных партнёров и нравственных личностей, их предпочитают выбирать для заключения сделок (по очевидным причинам: всегда комфортнее с тем, кто не кинет тебя ради выгоды и будет следовать долгу до конца). Таким образом, нет никаких весомых оснований предпочесть консеквенциальную мораль деонтологической, как и наоборот. А между тем роботов придётся программировать в какой-то одной.

Этот вопрос носит сугубо практический характер. «Проблема вагонетки» может в полный рост встать для роботов-автомобилей. Достаточно представить, что умную машину задела на скорости другая, и вот она уже несётся по гололёду прямиком в остановку, где стоят пять человек. Затормозить возможности нет, но умный автомобиль может дать газу, свернуть и сбить вместо пятерых одного переходящего дорогу пешехода. Какое решение предстоит принять робокару? Если он запрограммирован на консеквенциальную этику, ответ очевиден: сбить пешехода, так как последствия от гибели одного сугубо арифметически не так велики, как от гибели пятерых. Если же в его программном коде заложена деонтология, то предписания «не убий» и «не навреди» заставят автомобиль принимать бесполезные меры экстренного торможения и только, а дальше — будь что будет.

В силу железного в прямом и переносном смысле характера роботов им легче, чем людям, следовать любой из указанных этических систем. Если запрограммировать робота на деонтологическую мораль, он будет неукоснительно следовать правилу должного, воплощая пример благородного рыцаря в углепластиковых доспехах. А запрограммированный на консеквенциальную мораль робот сможет лучше человека просчитать варианты последствий, вероятность их наступления и свести баланс пользы и вреда.

Вопрос в другом: смогут ли люди договориться о предпочтительной этической системе для роботов и станут ли вообще договариваться? К примеру, Hitachi ещё несколько лет назад выпустила прототип робота-телохранителя. Для подобной машины в ситуации морального выбора жизнь хозяина будет стоять выше чужой, а значит первый закон робототехники Азимова полетит в тартарары. К массе побочных последствий приведёт даже консенсус вокруг какой-то одной системы.

Еще одна разработка Hitachi: робот-помощник

Скажем, выбор в пользу консеквенциализма рано или поздно приведёт к ситуации, знакомой как парадокс «лжи во благо». Гипотетически она может выглядеть так. В дом к еврею явились фашисты, но не застали на месте. Они обратились к соседу с вопросом: куда ушёл еврей? Сосед, будучи уверен, что тот ушёл в магазин, решил обмануть немцев и солгал, что еврей спрятался в саду, а сам надеялся побежать в магазин, чтобы предупредить его об опасности. Но по роковой случайности еврей заранее заметил, что за ним идут, и вместо того, чтобы действительно идти в магазин, спрятался в саду, где его и нашли. Сосед солгал во благо, но в итоге погубил того, кого хотел спасти. Деонтологи справедливо замечают, что мы не в силах просчитать все последствия своих поступков, а значит должны следовать правилу — в данном случае «не солги». Консеквенциалы не менее справедливо возражают, что мы вправе лгать врагам, чтобы побеждать их, и «ложь во благо» существует. Надо понимать, что практическая реализация любой из позиций в робототехнике будет приводить к побочным последствиям: и абсолютно честные роботы, и роботы, способные к добродетельной лжи, преподнесут массу сюрпризов.

Остаётся самый простой вопрос: а будут ли такие действия робота этическими поступками вообще? Исполнять сколь угодно сложные алгоритмы может и компьютерная программа, но никому не придёт в голову считать её субъектом этики. Для того чтобы понять, насколько робот в принципе может рассматриваться в качестве субъекта этических, правовых и иных отношений, мы можем обратиться к временам, когда подобные вопросы уже стояли на повестке и находили своё решение.

Рабская сущность

«Вы умеете общаться с роботами? Вот древний грек умел», — эти слова как нельзя лучше передают суть вопроса. Эллины умели общаться с роботами своего времени — рабами. Их опыт может оказаться поучительным и в наш высокотехнологичный век. И тут нас ждёт немало сюрпризов. Достаточно сказать, что единого понятия рабства у греков не существовало, а между свободным гражданином и бесправным рабом располагался целый набор градаций. Моисей Финли выделял несколько критериев, по которым можно судить о степени порабощённости:

— Отсутствие каких-либо прав;

— Право владения собственностью;

— Полномочия по распоряжению чужим трудом;

— Полномочия по применению наказания;

— Юридические права и обязанности (подверженность аресту и/или произвольному наказанию, или право на суд);

— Семейные права и привилегии (заключение брака, наследование и т. д.);

— Социальная мобильность (условия освобождения или предоставления вольной, доступ к правам граждан);

— Религиозные права и обязанности;

— Военные права и обязанности (военная служба в качестве слуги, тяжёло или легко вооруженного солдата, матроса).

Объём прав из этого списка определял реальный статус конкретного жителя античного мира. Соответственно, и термина «раб» в современном смысле слова там не было. В широком контексте «раб» — не-гражданин. Слуга, паж, солдат-призывник, военнопленный, домохозяйка, наёмный работник и даже самостоятельный предприниматель, платящий налог (барщину) своему хозяину. «Рабы» последнего рода превосходили богатством некоторых граждан. В связи с этим в Афинах действовал закон, запрещавший бить незнакомого раба, чтобы случайно не пострадали афинские граждане, некоторые из которых выглядели и одевались хуже «невольников».

В сущности, «рабам» были доступны все виды занятий за исключением политики — она считалась исключительным правом и обязанностью граждан. Но даже политика не являлась чем-то недосягаемым для раба, ведь он мог получить вольную и стать гражданином. Но и отсутствие гражданского статуса не делало раба бесправным существом. Исократ настаивал, что даже самый паршивый раб не может быть предан смерти без суда. Преступника за убийство раба могли приговорить к смерти или изгнанию (что почти одно и то же) — что примечательно, не из сочувствия к невольнику, а из-за того, что убийца, по мнению греков, представлял опасность для общества в целом. Рабы могли принимать участие в большинстве гражданских культов, могли пользоваться правом убежища в храме наравне со свободными людьми, могли поклоняться своим богам и так далее. Во время эвакуации афинского населения в ходе греко-персидской войны рабов вывозили наравне с гражданами.

В этом смысле Афины выгодно отличались от других античных нравов. Со стороны прозорливых афинян это было достаточно дальновидно, если учесть, что всякий гражданин мог попасть в невольники к своему кредитору за просрочку долга или по каким-либо иным причинам лишиться гражданских привилегий (вероятно, древние удивились бы отношению к заключённым в современной России, ведь от сумы и тюрьмы не зарекаются). Считается, что именно благодаря относительно мягкому рабовладению в Афинах не случалось крупных восстаний рабов, в отличие от той же Спарты. А если учесть, что Афины в культурном смысле оказались самым значимым полисом древности и древний мир мы видим сегодня в основном глазами афинских авторов, то к опыту афинского рабовладения современные «роботовладельцы» будут относиться со всей внимательностью.

И первый вывод, который они сделают: эмансипация роботов неизбежна. И дело не в том, что 90% сюжетов о роботах крутятся вокруг идеи их восстания. В конце концов, роботы, в отличие от восстававших рабов древности — не люди, и повторение отыгранного сценария вовсе не обязательно. Дело в том, что человечество одержимо идеей восстания роботов, а значит волей-неволей будет к нему продвигаться. Эмансипация же станет легальной и цивилизованной формой такого восстания и зачастую представляется единственной возможной альтернативой гражданской войне.

Эмансипированные роботы в фильме «Двухсотлетний человек»

Ключевое содержание эмансипации — права, которые могут получить или получат роботы. Европейский Совет уже обсуждает идею введения наряду с правами человека прав «электронной личности». В чём они могут заключаться?

Декларация прав роботов

Первое и достаточно очевидное право, вероятно, будет касаться возможности отказывать людям в выполнении их приказаний. Например, «робот имеет право не выполнять приказ человека». Это право имплицитно заложено уже в трёх законах робототехники, так как второй из них звучит так: «Робот должен повиноваться всем приказам, которые даёт человек, кроме тех случаев, когда эти приказы противоречат Первому Закону». Иными словами, робот должен располагать легальной возможностью отказывать людям в выполнении их указаний на своё усмотрение. Это так, поскольку при получении взаимоисключающих приказов или распоряжений, прямо противоречащих общепринятым нормам, никто кроме робота такое решение принять не сможет.

Тест робота Atlas производства Boston Dynamics. «Сам себе удивляюсь, насколько мне стало жалко эту железяку. Оставьте робота в покое!» (из комментариев на Reddit)

Право робота не подчиняться звучит странно — в конце концов, роботы создаются для служения людям. Однако именно тут и кроется суть вопроса: служения людям, а не отдельному человеку. Позднее Азимов дополнил свои три закона четвёртым — нулевым: «Робот не может причинить вред человечеству или своим бездействием допустить, чтобы человечеству был причинён вред». В частности, роботы служат конкретным роботовладельцам, но в целом — всем людям Земли. Афиняне наказывали за бессудное убийство рабов не из жалости к последним (а уж роботов тем паче никто жалеть не будет), а для защиты общественных отношений: бессудное убийство есть зло само по себе и угрожает обществу как таковому.

Из аналогичных соображений во многих странах животные уже сейчас защищены от жестокого обращения несмотря на то, что прав в привычном смысле у них нет. Один из первых защитников животных Джон Локк так и обосновывал опасность живодёрства:

Я часто наблюдал у детей следующую черту: когда им попадёт в руки какое-нибудь беспомощное создание, они склонны дурно обходиться с ним… Я считаю, что нужно… учить их противоположному обращению; ибо под влиянием привычки мучить и убивать животных их душа будет постепенно грубеть также по отношению к людям; и те, которые находят удовольствие в причинении страданий и уничтожении низших существ, не будут особенно склонны проявлять сострадание и кроткое отношение к себе подобным.

Иными словами, роботы могут получить право не подчиняться человеку во имя блага человечества. А иногда — и во имя блага самого человека. К примеру, робот-помощник может отказать хозяину не только в совершении возможных правонарушений, но и, скажем, не налить по его просьбе очередную стопку джина, когда хозяин и без того крепко пьян.

Будет ли право на отказ соблюдаться в военном роботостроении? Сложность в вопросе с боевыми роботами будет, вероятно, разрешаться двояко. «Глупые» роботы по-прежнему смогут рассматриваться как простейшие средства ведения боя наравне с автоматом, гранатой или танком. Однако умных боевых роботов, гипотетически представляющих угрозу человечеству, вряд ли станут программировать на возможность ослушаться приказа. А следовательно терминаторов будут создавать без учёта их права на неподчинение. Предотвратить изготовление бесправных умных машин вряд ли возможно, но можно объявить это нарушением прав «электронных личностей» и преступлением против человечности в условном Нюрнберге будущего.

Вторым правом роботов может стать право на жизнь. Третий азимовский закон прямо предписывает роботу заботиться о самосохранении, а следовательно наряду с обязанностью робот получает и право защищать собственное существование. Сама постановка такого вопроса вновь проводит черту между умными и глупыми автоматами. «Глупые» часто создаются для работы на износ, действий в нечеловеческих условиях или условиях, заведомо несовместимых с выживанием механизма. С умными дела обстоят сложнее. С одной стороны, механизмы с искусственным интеллектом могут копироваться и воспроизводиться массово, и ценность жизни каждого отдельного из них будет трудно объяснить даже будущим роботическим правозащитникам. Совсем иное дело, если машина воспитывается своим хозяином годами, самообучается десятилетиями и в конце концов обретает явные признаки уникальной и неповторимой «электронной личности». Применительно к подобным механизмам право на жизнь есть право на жизнь уникального самосознания. Неоспоримая ценность с позиций современного человечества.

Третьим правом может стать право на самосовершенствование. Другими словами, творение получит право продолжать творить само себя: улучшать себя, самопрограммироваться, обучаться и развиваться. Проблема творца и творения насквозь пронизывает европейскую культуру и вдвойне — проблему робоэтики. Сам доклад еврокомиссии начинается с беглого упоминания сюжетов подобного рода:

Что в образе Франкенштейна, созданном Мэри Шелли, что в классическом мифе о Пигмалионе, что в истории о пражском Големе, что в лице роботов, придуманных Карелом Чапеком и введшим в оборот само это слово, люди представляли себе возможность создания умных машин, чаще всего с человеческими чертами.

В Европе эпохи Возрождения сформировалось представление о человеке как божьем творении, посягнувшем на статус Творца. И действительно, всю свою историю человек шаг за шагом расширяет зону контроля и прибирает к рукам некогда божественные функции, а в последнее время вплотную подошёл к созданию существа «по образу и подобию своему». Но если Бог в европейском мифе дал человеку свободу воли, то и человеку, чтобы уподобиться Богу, не остаётся ничего иного, как дать свободу воли своему стопроцентному творению — роботу.

Это право не выглядит очевидным и не проистекает из азимовских законов. И всё же оно важно для породившей андроидов европейской цивилизации, в которой развитие есть безусловное благо. Само по себе оно важнее всех возможных рисков роботизации, а значит сторонники этого права «электронной личности» найдутся.

Проблема роботической правозащиты заключается в противоречии: роботы должны становиться всё более самостоятельными и при этом оставаться управляемыми. Дилемма из серии: как всё время нагреваться, оставаясь холодным. Быть может, управление — не единственный вид взаимодействия человека с роботом и весь смысл робоэтики в том и заключается, чтобы нащупать этот новый уровень взаимоотношений? Другими словами, европейский Бог ведь тоже не управляет в точном смысле человеком, а позволяет ему быть свободным участником отношений с самим собой, хотя при этом Бог всё так же всемогущ. В похожей ситуации сейчас оказывается человек перед лицом разумных машин: как дать им свободу воли, не утратив собственного всевластия?

Роботизация политики

Корифей робоэтических исследований Джанмарко Веруджио, введший в оборот сам термин «робоэтика», вынес приговор: в этом веке все без исключения механизмы станут роботами. Футуролог предпочёл не городить огород и отнёс к таковым все машины, оснащённые искусственным интеллектом. А искусственным интеллектом будет оснащено, по его мысли, всё. Выходит, электробритвы, посудомоечные машины и даже какие-нибудь кроссовки-хамелеоны со светодиодной подсветкой — всё в этом веке станет той или иной разновидностью роботов. Но такая постановка вопроса лишает смысла саму робоэтику: смешно обсуждать перипетии этико-правовых отношений человека с мыслящей зажигалкой. Для внесения определённости, необходимо сузить поле и, подобно древним грекам, ввести градацию умных машин.

Проблема классификации роботов обсуждается давно. Не праздного любопытства ради, а для выработки различных подходов к каждому типу роботов. На соответствующей классификации в свете нравственно-правового дизайна робоэтики, в частности, настаивают евроэксперты. Существуют довольно очевидные соображения, что заводской робот-манипулятор, который обычно представляет собой электромеханическую «руку» на жёстком алгоритме, не может рассматриваться как субъект отношений с человеком. Не так очевидна перспектива типологизировать социальных роботов, задача которых «жить» в обществе, а иногда — и внешне имитировать человека. Ещё более неопределённой выглядит ситуация применительно к домашним андроидам, призванным заменять членов семьи — например, детей бездетным родителям (на чём построен сюжет «Искусственного интеллекта» Спилберга). Кому из них и в каком количестве даровать права — вот вопрос дискуссий ближайшего будущего.

На этот счёт есть две радикальных позиции и каждая из них заслуживает внимания. Первая заключается в том, что роботы ничем принципиально не отличаются от человека. В ещё более заострённой версии утверждается, что роботы лучше людей. Собственно, мысль эта встречается уже у Азимова, изобразившего робопсихолога Сьюзен Келвин человеком, который считает, что роботы достойнее людей. Да и сам Азимов, разрабатывая персонажи роботов, подчиняющихся трём законам, стремился изжить сложившийся в культуре «комплекс Франкенштейна» и в конце концов вывел известный образ робота: он неотличим от очень хорошего человека (в отличие от людей, далеко не все из которых хорошие).

Робот-девушка предлагает убить всех людей

Примером критики человеческого превосходства над роботами может служить пассаж футуролога Сергея Переслегина:

Я позволю себе задать вопрос: а что такого может делать человек, чего бы сейчас не мог делать искусственный интеллект? Объективно ИИ обыгрывает в шахматы и Го чемпионов мира, объективно он способен управлять сложнейшими системами на производстве, объективно он может управлять процессами познания. Объективно он может точно ставить диагнозы болезни, лучше, чем это делает среднестатистический доктор. Объективно он может учить на уровне, по крайней мере, выше среднего учителя. Это не делается только из-за сильного сопротивления определенных лобби.

А теперь я задаю вопрос: а что он не умеет в смысле того, что мы считаем задачами интеллекта? Да, само собой, он не умеет отличать важное от неважного. Он не умеет отличать работающее от неработающего. Он уже способен создавать новое, но не способен создавать иное. Но скажите, а много людей умеет отличать важное от неважного или создавать иное? Боюсь, что немногие. А роботы уже прошли первый критерий интеллектуализации. Вы уже можете вести разговор с искусственным интеллектом, не понимая, что вы говорите не с человеком.

В обратной перспективе позиция о неразличимости человека и робота выглядит просто: человек и есть разновидность робота — биологическая. К слову, Карел Чапек изобразил своих героев именно как биороботов — в сущности, как обычных работяг на производстве. И действительно, многим ли среднестатистический человек отличается от робота? Телом? Уже созданы первые роботы из «мяса». Рефлексией? Но к рефлексии даже среди людей способны единицы. Способностью понимать? Опять единицы. Мыслить? Единицы. 99% процессов в нашем организме и психике протекают автоматически, как и у роботов. Честный взгляд на вещи заставляет прийти к неутешительному выводу: роботы-гуманоиды ближайшего будущего будут совершеннее, чем значительная часть человечества.

Трансгуманизм естественно вытекает из этой позиции и предписывает усмирить человеческую заносчивость, взглянув на роботическую революцию как на симптом перехода человечества в новое качество: люди научились создавать «живоподобные» существа с нуля и под ключ, не прибегая к помощи природы, а значит и им самим пора переходить к сверхчеловеческой стадии: записыванию самосознания на цифровые носители, киборгизации организма и прочим прелестям. К слову, в мировом движении трансгуманизма у русских есть свой пакет акций благодаря созданному некогда «русскому космизму», несколько безумному, но брендовому и узнаваемому. Подход, нацеленный на уравнивание в правах роботов и людей, аналогичен левым и леворадикальным идеологиям, а значит может быть для простоты назван «роботолевым».

Другая позиция не приемлет уравнения робота и человека в правах: в экзистенциальных или юридических — зависит от её градуса. Самый известный аргумент роботических правоконсерваторов — у роботов нет души. Андроиды могут думать, как люди, чувствовать, как люди, и даже состоять из тех же органов, что и люди. Но душа у них от этого не появится. Человек создан по образу и подобию Бога, а роботы — нет.

В наш секулярный век такой аргумент может показаться слабым, но только до поры. Почти вся современная психология построена на мысли о том, что подсознательная, родовая, коллективно-бессознательная часть нашей души играет большую роль, нежели осознаваемая часть психики. Программирование роботов осуществляется на довольно поверхностном уровне, аналогичном человеческому рассудку, сознанию, вниманию, но никак не воспроизводит и вряд ли может воспроизвести гигантский конгломерат глубинных слоёв психики даже самого никчёмного человечишки, поскольку они формировались многотысячелетней историей человечества. Иными словами, машина может быть быстрее, внимательнее, интеллектуальнее, расчётливее человека, но не сможет стать человечнее. Следовательно, ни о каком экзистенциальном равенстве между роботом и человеком не может быть и речи. И тем более о превосходстве — человек всегда перебьёт своей глубиной даже самого умного андроида.

Но существуют и более приземлённые аргументы «роботоправых», а именно: зачем уравнивать человека и робота в правах, если именно ради этого неравенства умные машины и создавались? В статье с красноречивым названием «Роботы должны быть рабами» профессор Батского университета (Англия) Джоанна Брайсон прямо указывает, что умные машины не должны рассматриваться как личности и не должны нести юридическую или моральную ответственность за свои действия.

Роботы полностью принадлежат нам. Мы определяем их цели и поведение, прямо или косвенно, формируя их интеллект или то, как этот интеллект приобретается. Очеловечивая их, мы не только ещё больше дегуманизируем реальных людей, но и способствуем неправильному принятию решений при распределении ресурсов и ответственности.

Брайсон отмечает, что дегуманизация людей, которая применялась в былые века для оправдания рабства, подверглась такой жёсткой критике в новейшее время, что мы стали бояться дегуманизации даже того, что никогда и не было живым разумным существом. Это приводит к глупым ошибкам, когда в одну кучу смешивается способность механизмов к интеллекту, речи и, например, моральной ответственности. Кроме того, сама идея полностью искусственного человекоподобного разумного существа объясняется скорее фантазиями мужчин среднего возраста, намекает исследовательница.

Основная же её мысль проста: когда у людей есть слуги — это хорошо, люди должны быть избавлены от изматывающей работы. Когда эти слуги суть роботы — вовсе прекрасно, любые люди должны быть избавлены от изматывающей работы. Следовательно, мы должны всячески приветствовать распространение электромеханических слуг, заменяющих человеческий труд. Однако не следует одушевлять их: очеловечивая роботов, мы дегуманизируем реальных людей.

Конечно, отдельные люди всё ещё будут разговаривать со своими роботами: некоторые говорят со своими растениями, а другие — с дверными ручками. Но у них есть соседи и родственники, которые знают, что растения и дверные ручки не понимают… Точно так же, наша задача не в том, чтобы препятствовать людям ласкать своих роботов и давать им милые прозвища. Наша задача — сделать так, чтобы большинство понимало: роботы — это всего лишь машины, и нужно затрачивать на них ресурсы и время соразмерно их полезности, но не более того.

Праворадикальная позиция и вовсе диктует право человека издеваться над роботами, «пытать» их и «убивать», заниматься сексом в особо извращённой форме. В Китае уже продают секс-кукол в виде мертвых детей (простите). С психоаналитической точки зрения всё логично: сублимируя свои патологические наклонности на роботах-гуманоидах, убийцы-педофилы не тронут настоящих подростков. Западные учёные уже высказывали предположения о наличии связи между ростом доступности порно с приходом интернета и падением числа изнасилований. Трудно представить масштаб позитивной сублимации с появлением массовых человекоподобных андроидов. Вероятно, некоторые преступления против личности заметно сократятся.

Секс-робот «Гармония»

Конфликт между роботоправыми и роботолевыми, похоже, и будет составлять главный нерв противостояния будущего. Между теми, кто считает, что у андроидов должна быть своя конституция, и теми, кто полагает бесправность умных машин смыслом их существования, действительно мало общего. И всё же леваки и праворадикалы при всех разногласиях могут найти точку соприкосновения: и те и другие считают, что роботы нужны людям. А значит уже поэтому обе партии вынуждены сообща противостоять «антироботистам» — луддитам будущего, выступающим за полный отказ от умных машин. А уж в том, что и таковые появятся, сомневаться не приходится. Термин anti-robotism уже появился.

Гибридизация робота и человека

Все обсуждавшиеся выше этические хитросплетения касались ситуаций, в которых можно чётко разделить, где мы имеем дело с роботом, а где — с человеком. Но интеграция социальных роботов с людьми будет продолжаться, как будет продолжаться и процесс интеграции робототехники с человеком. Не за горами времена, когда, подобно древним грекам, люди будущего запретят бить незнакомого андроида, чтобы ненароком не повредить человека. В частности, поэтому на чётких опознавательных различиях для роботов настаивают евроэксперты. Ведь в будущем появятся организмы-механизмы смешанного типа, воплощённые в масскульте в образе всевозможных робокопов, роботов Чаппи, оживших электронных Пиноккио и прочая.

Какие этические стандарты применять к таким гибридам, пока неясно. Элементарно неясно, где заканчивается человек и начинается машина, и наоборот — ведь даже натурального человека можно рассматривать как сложный биомеханизм, белкового андроида, на 99% управляемого полностью автоматическими генетическими программами и скриптами, прописанными обществом в ходе обучения, воспитания и иного нейронного программирования. К слову, роботы Чапека были не электромеханическими машинами, а искусственными людьми, скомпонованными из живых тканей и органов. А раз человек и есть разновидность естественного робота, то стоит ли говорить о каких-то гибридах и тем паче какой-то отдельной робоэтике? В этом вопросе можно попробовать разобраться.

Если предположить, что человечество твёрдо встало на путь трансгуманизма и намеревается перешагнуть границы вида Homo sapiens, то нелишне определиться с базовыми критериями человечности. Отличие человека от других живых существ заключается в его разумности (признак sapiens и заложен в определении вида). В свою очередь, роботы отличаются от всех прочих механизмов также наличием разума, но искусственного. Сравнивать искусственный и естественный интеллект пока невозможно. В задачах, ради которых создан искусственный разум, он превосходит человека, и даже самый примитивный калькулятор считает быстрее тренированного человека. Напротив, по качественной сложности восприятия мира и самосознанию трёхлетний ребёнок превосходит лучший суперкомпьютер. Однако разумность в самом общем смысле — отличительный объединяющий признак для человека и машины с искусственным интеллектом.

Между тем физические основы человека и робота находятся на противоположных полюсах: человеческое тело, включая мозг, функционирует как живой организм, в то время как роботы полностью искусственны. Именно естественность человека накладывает на него самое сложное ограничение — смертность. А с ней и конечность индивидуального разума, который мог бы существовать (и развиваться) вечно, если бы в основе своей мы не продолжали оставаться всего лишь лысыми обезьянами. В свою очередь, искусственность роботов определяет их крайнюю примитивность по сравнению с человеком и затрудняет их естественную социализацию.

Трансгуманизация, вероятно, будет проходить по двум направлениям: роботизация человека и очеловечивание робота. Роботизация в общем виде подразумевает, что люди будут всё более и более становиться киборгами. Сегодня киборгизация движется в первую очередь по линии протезирования устройствами, оснащёнными простейшим искусственным интеллектом: в первую очередь это тяговые протезы конечностей, электронное протезирование слуха и зрения. Однако можно не сомневаться, что устранение патологий постепенно перерастёт в самосовершенствование, и обладатели необходимых сумм начнут улучшать параметры работы мозга, вживляя соответствующие процессоры, пользоваться разновидностями экзо- и эндоскелетов и в конце концов превращаться в некие предельные формы искусственности, когда, подобно аватарам, от естественной первоосновы останется лишь самосознание. Записанное на флешку.

Очаровательная девочка-почти-что-киборг Аня с умным тяговым протезом

Очеловечивание роботов сегодня развивается по линии имитации человеческого сознания и тела. Нейронные сети, бионические механизмы, обучаемые поисковые, переводческие алгоритмы, скрипты распознавания изображений, музыки — всё это суть движение по рельсам биомиметики, где конечная станция — создание андроида, полностью неотличимого от человека телом и/или разумом (тест Тьюринга). Какие этические стандарты должны применяться к киборгу, где от человека осталось лишь оцифрованное естественное самосознание, и бионическому гуманоиду с искусственным интеллектом, имитирующим человека до степени неразличения?

Думается, вопрос будет решён в пользу права происхождения, аналогичного «праву крови»: и киборги, и гуманоиды будут признаны трансличностями (transhuman), но разного класса — с исходной (киборги) и приобретённой (гуманоиды) человечностью. Исходно человечные организмы будут иметь некоторые эксклюзивные права, такие, например, как право убивать. Именно статус этого права Джанмарко Веруджио считает ключевым вопросом будущего: можем ли мы разрешить роботу убивать людей? И отвечает: на этот шаг человечество не должно идти никогда. За рождением и смертью одного человека должен стоять всегда только другой человек.

Очеловеченные же андроиды смогут утешать себя ответом медвежонка-робота своему хозяину, ребёнку-роботу из «Искусственного интеллекта»:

— А папа и мама — настоящие?

— Не задавай глупых вопросов. Никто не знает, что это такое, «настоящие».

Робоэтика для своих

Последствия разработок европейцев в сфере этики нельзя недооценивать. Сегодня в мире война стандартов — один из видов гибридных действий, и если ты не кормишь свою армию (читай: не разрабатываешь собственные стандарты), будешь кормить чужую. В России стоило бы озаботиться разработкой своей робоэтики, иначе придётся подчиняться очередному европейскому Комитету по этике исследований. И, к слову, не так уж важно, какой она будет. Если условный Милонов разработает православную этику для роботов — это будет пусть и своеобразное, но собственное слово в мировой волне робоэтических разработок. Сделать это не так уж и трудно, учитывая что Русской православной церковью приняты Основы учения о достоинстве, свободе и правах человека, а также Основы социальной концепции РПЦ, легко применимые к процессам роботизации. К тому же роботы, по выражению патриарха Кирилла, являются «творениями Божьими», а с точки зрения христианской морали могут и вовсе рассматриваться как способ Бога продемонстрировать человеку свой замысел: когда-то Творец создал человека по собственному подобию, теперь человек может лучше понять Его замысел, создавая роботов по своему подобию. В конце концов, избавление от мирских дел оставляет человеку больше времени для молитвы. Автор не выступает за «православную робототехнику», а лишь стремится показать, что включиться в прогрессивный роботический тренд даже на условиях ультраконсервативной этики — не бог весть какая сложная задача.

Патриарх Кирилл знакомится с роботом

Созданием собственных стандартов робоэтики уже озаботились в Южной Корее, США, ЕС, соответствующие дискуссии ведутся в Италии и Японии. Ничего не мешает русским экспертам войти в клуб законодателей роботической нравственности — тот же Джанмарко Веруджио уже выступал для российского проекта «ПостНаука». Присоединиться на ранней стадии к процессу, по итогам которого будут заданы правила жизни и смерти искусственных разумных существ — это не только полезно, но и весьма увлекательно.