Позавчера университет Рединга сообщил о том, что известный тест, проверяющий наличие интеллекта у компьютера, был пройден. В сети появилась масса публикаций и перепечаток этой новости. Во многих из них пророчат наступление постчеловеческой эры, расцвет цивилизации — или её гибель. Однако такие оценки, безусловно, являются предвзятыми. Попробуем же спокойно взглянуть на сам эксперимент.

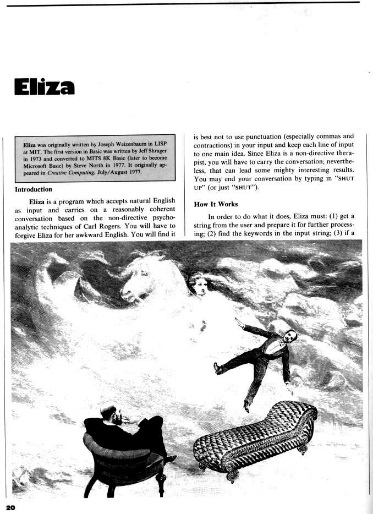

Впервые идея теста была предложена легендарным британским математиком и логиком Аланом Тьюрингом в 1950-м году. Тест должен был определить, может ли мыслить испытываемая машина. Его формулировка менялась несколько раз, но в текущем виде она звучит так: «Если человек не может понять, общается ли он с компьютером или другим человеком, то компьютер проходит тест Тьюринга». Простые условия, неограниченные рамки, и, конечно, авторитет великого учёного привели к тому, что уже на протяжении более 60 лет исследователи пытаются создать программу, способную убедить жюри в том, что она является человеком. В 1966-м году была создана «ELIZA», один из первых примеров виртуальных собеседников. Наиболее известен скрипт «DOCTOR», частично имитирующий первичную беседу с психотерапевтом. Несмотря на то, что программа была очень простой и фактически лишь меняла формулировку вопросов (—Мой отец ненавидит меня. — Кто ещё в вашей семье ненавидит вас?), некоторые испытуемые всерьёз верили в то, что общаются с человеком.

Через тринадцать лет появился другой, более продвинутый собеседник «PARRY». Бот пытался сыграть роль параноидального шизофреника, и иногда вёл себя очень грубо.

Человек: Вы связаны с мафией?

PARRY: Вы знаете, они меня знают.

Человек: Каким образом они знают о вас?

PARRY: Они шпионят за мной.

Человек: Зачем они это делают?

PARRY: Они хотят получить фальшивые доказательства, чтобы подставить меня.

Человек: Почему они хотят сделать это с вами?

PARRY: Они хотят разделаться со мной.

Человек: Почему?

PARRY: У меня есть изобличающие улики на мафию.

Человек: Вы уверены во всём этом?

PARRY: Вы мне не верите?

В 1990-м году для награждения программ, прошедших тест, была учреждена специальная премия Лёбнера. Правила конкурса периодически модифицировались: с 1995 года темы разговора больше никак не ограничиваются, а время увеличилось с 5 минут до 20. В 2014-м году премия Лёбнера ещё не вручалась, испытание пройдёт в ноябре. Важно отметить, что теперь это лишь один из многих конкурсов.

Бот университета Рединга, послуживший поводом для стольких новостных заголовков, был создан русскими учёными и уже побеждал в масштабном конкурсе Turing100. По легенде, Евгению Густману 13 лет, он живёт в Одессе и у него есть морская свинка. Правда, тогда он смог убедить лишь 29% судей, что является человеком. У разных конкурсов — разные критерии, и нужно понимать, что теоретически любой университет может проводить свои собственные испытания. В этом же соревновании маркером прохождения теста является планка в 30% судей. В этом июне «Евгений» смог убедить 33% судей.

К сожалению, Тьюринг не описал подробностей проведения теста, и ясно, что победа «Густмана» не означает, что человечество уже больше не нужно. Однако представим себе идеального бота, который будет убеждать всех судей. Будет ли это означать, что создан настоящий искусственный разум?

Претензии к тесту Тьюринга выдвигаются давно. Одной из самых известных концепций является «Китайская комната», предложенная американским философом Джоном Сёрлем.

Он описал некую систему, проходящую тест Тьюринга, однако при этом не понимающую значения входных или выходных данных. В систему входит человек, знающий лишь английский язык, книга с правилами на английском языке, а также листы. На части листов написаны непонятные символы, а часть из них — пусты. В комнате, где находится система, есть отверстие. В этом отверстии появляются листы бумаги с символами. Человек открывает книгу правил и следует инструкциям. Инструкции могут предусматривать помещение символов, их поиск, перемешивание листов и так далее. В конце всё сводится к написанию символов на пустых листках, которые человек затем передаёт наружу.

Внешний наблюдатель видит систему, принимающую информацию в форме текстов на китайском языке и отвечающую тоже на китайском. Но человек в комнате, по условию эксперимента, не знает этого языка.

Как написал Сёрль, «В ответ, выполнив предписанные правилами манипуляции, я выдам символы, мне также непонятные и означающие, что мой любимый цвет синий, но мне также очень нравится зелёный. Таким образом, я выдержу тест Тьюринга на понимание китайского языка. Но все же на самом деле я не понимаю ни слова по-китайски. К тому же я никак не могу научиться этому языку в рассматриваемой системе, поскольку не существует никакого способа, с помощью которого я мог бы узнать смысл хотя бы одного символа. Подобно компьютеру, я манипулирую символами, но не могу придать им какого бы то ни было смысла».

Лем приводит другой любопытный пример. Предположим, что у нас есть мозаика, состоящая из большого количества фрагментов. На ней может быть изображено что угодно: морские пейзажи, чертеж или «Мона Лиза». Человек собирает мозаику, руководствуясь не только формой кусочков, но и анализируя изображение на них. Однако если мы попросим некоего субъекта собрать картину, перевернув все кусочки, в конце концов ему это удастся. Если мы затем снова перевернём уже собранную мозаику, то увидим «Мону Лизу», даже если субъект и не знал о том, какой образ он воссоздавал.

Гектор Левек, канадский исследователь, в своей статье «On our best behavior» обрушивается на концепцию теста Тьюринга и утверждает, что, по сути, все эти боты лишь обманывают и пытаются убедить судей уловками. Левек со своим коллегами предлагает ввести новые вопросы, базирующиеся на так называемых «Схемах Винограда», на которые программе будет сложно ответить.

Например:

«Трофей не влезал в коричневый чемодан, потому что он был очень маленьким. Что было таким маленьким?

— трофей

— коричневый чемодан»

«Большой шар проделал дыру в столе, потому что он был сделан из пенопласта. Что было сделано из пенопласта?

— большой шар

— стол»

В конце статьи Левек дает совет всему сообществу исследователей:

«Мы должны избегать чрезмерного увлечения тем подходом, который кажется наиболее многообещающим на сегодняшний день».

У теста Тьюринга масса других недостатков. Программа может пройти тест при одном испытании и провалить его на следующем, субъективность комиссии (ведь даже простую «ELIZA» многие пациенты воспринимали как человека!) и так далее. В 2008-м году сотрудники газеты «Троицкий вариант» с помощью программы «SCI gen» сгенерировали научную статью «Корчеватель: Алгоритм типичной унификации точек доступа и избыточности», затем отправленную в научный журнал. Статья была принята к печати и опубликована. Однако никто не спешит признать «SCI gen» разумным.

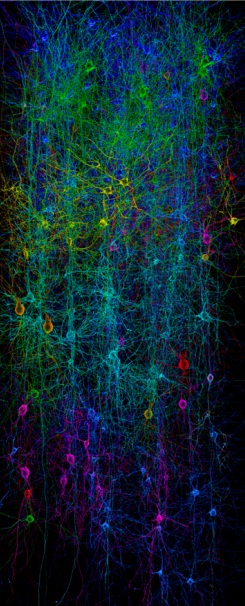

Исследование искусственного интеллекта воистину является наиболее сложной задачей, решаемой учёными. В ней смешаны философия, лингвистика, психология, биология, математика и информатика. Проблемы возникают с самого начала: даже об определении слова «интеллект» идут яростные споры. Так, часть исследователей считает, что воссоздание разума невозможно без подробного анализа нашего мозга. Одним из проектов, посвящённых этой задаче, является «Blue Brain Project», спонсируемый компанией IBM. Основной его задачей является создание модели головного мозга млекопитающих. Она должна основываться не на уже существующих нейросетях, а на биологически достоверных нейронных моделях.

Компьютерная модель колонки кортекса крысы

На заре информатики критерием машинного разума служила игра в шахматы. Однако компьютер уже давно обыграл человека, но не стал от этого разумнее. Видимо, тест Тьюринга тоже сдает свои позиции. Но не стоит расстраиваться, что в этом году не получится поболтать с чутким роботом: любой прорыв в этой сфере неизбежно ведёт нас к эпохе технологической сингулярности. Впрочем, готовиться к открытиям нужно уже сейчас. Например, в Кембридже несколько лет назад появилась специальность «Информатика и философия», где студенты будут изучать ИИ, логику, роботов и виртуальную реальность. В этом же университете прекрасно понимают и тёмную сторону технологий, поэтому в Кембриджском центре изучения экзистенциальных рисков среди прочих опасностей есть и искусственный интеллект.

Мы быстро привыкаем к различным научным открытиям и инновациям. Нетрудно представить, как легко согласиться с мыслью о том, что наша жизнь будет длиться несколько столетий, или представить себе персональный авиамобиль. Однако некоторые изобретения, такие как бессмертие или искусственный интеллект, изменят жизнь человечества таким образом, что она станет в корне иной. Нашему поколению выпала редкая возможность запечатлеть в своей памяти старый мир. Это дивный момент, который следует прочувствовать и осознать. Пока мы ещё люди.